Dans un contexte où l’IA générative est souvent synonyme de services cloud et d’abonnements, LLM Studio offre une alternative intéressante : faire tourner vos propres modèles de langage directement sur votre ordinateur. Cette leçon vous montre comment transformer un simple poste de travail en “machine IA” locale, afin d’expérimenter, prototyper ou former vos publics sans exposer systématiquement vos données à des plateformes externes.

À l’issue de cette leçon, vous saurez :

- ce qu’est LLM Studio et à quoi il sert ;

- sur quel type de machine il est pertinent de l’installer ;

- comment l’installer, télécharger un modèle et commencer à discuter avec lui ;

- comment exposer une API locale compatible OpenAI pour vos propres outils.

Les éléments de cette leçon s’appuient principalement sur la documentation officielle de LLM Studio et quelques guides d’utilisation d’LLM en local (sources : lmstudio.ai, documentation de l’application, documentation serveur local, article CodeGPT sur LLM Studio).

1. LLM Studio en deux mots

LLM Studio est une application de bureau qui permet d’exécuter en local des modèles de langage (LLM) comme Llama, DeepSeek, Qwen, Phi ou Mistral directement sur votre ordinateur Windows, macOS ou Linux. Vous interagissez avec ces modèles via une interface de type « chat », proche de l’expérience que vous connaissez déjà avec les IA en ligne (source : site officiel LLM Studio).

L’outil télécharge les modèles depuis des dépôts comme Hugging Face, les stocke sur votre disque et les charge en mémoire au moment de l’utilisation (source : documentation LLM Studio – App).

Concrètement, vous disposez d’un « ChatGPT-like » sur votre machine : vous ne dépendrez plus d’un service cloud pour vos tests internes, et vous garderez la maîtrise de vos données.

2. Pour qui et pour quels usages ?

LLM Studio est particulièrement pertinent pour plusieurs profils :

Formateurs et centres de formation

Vous pouvez démontrer ce qu’est un LLM de façon concrète, en local, sans imposer la création de comptes en ligne à vos stagiaires. L’outil devient un support pratique pour aborder les notions de modèles de langage, de prompts et de paramètres de génération.

TPE/PME manipulant des données sensibles

Pour des contenus RH, juridiques, financiers ou techniques, un modèle local limite l’exposition de vos données à des services externes. Votre texte reste sur votre machine ou votre réseau interne, ce qui est cohérent avec une démarche de maîtrise des données.

Développeurs, power users et équipes techniques

LLM Studio expose une API locale (HTTP) compatible avec le format OpenAI : vous pouvez donc connecter vos scripts, vos outils no-code ou vos automatisations à un modèle local, en adaptant simplement l’URL et la clé d’API (source : documentation serveur LLM Studio).

[Inference] En revanche, ce n’est pas une solution universelle : sur du matériel modeste, la génération sera plus lente que sur des offres cloud haut de gamme, et certains modèles très volumineux seront hors de portée.3. Pré-requis matériels et logiciels

Les pré-requis exacts dépendent du modèle choisi (taille, quantization, architecture), mais les repères ci-dessous sont cohérents avec les guides disponibles sur les LLM en local (sources : documentation LLM Studio, guide XDA sur les LLM locaux).

Système d’exploitation

LLM Studio est disponible pour Windows, macOS et Linux. (lmstudio.ai)

Processeur, mémoire et GPU

LLM Studio peut fonctionner uniquement sur CPU, mais les performances restent limitées pour les modèles les plus complexes. Le logiciel sait tirer parti de nombreux GPU (y compris des GPU intégrés, via Vulkan) pour accélérer la génération (sources : documentation LLM Studio, XDA – LLM en local).

Pour un usage confortable avec des modèles de taille moyenne, un point de départ raisonnable est :

- au moins 16 Go de RAM pour garder de la marge ;

- un processeur récent (Intel, AMD ou Apple Silicon) ;

- un GPU dédié ou intégré récent si vous souhaitez des temps de réponse plus fluides.

Espace disque

Les modèles pèsent plusieurs gigaoctets. Selon la taille du modèle et le niveau de quantization, comptez en général entre 4 et 10 Go (ou davantage) par modèle installé (source : documentation et fiches de modèles sur Hugging Face).

Étape 1 – Installer LLM Studio

Pour installer LLM Studio, vous pouvez suivre les étapes suivantes :

- Rendez-vous sur le site officiel lmstudio.ai.

- Accédez à la section de téléchargement et choisissez l’installateur correspondant à votre système (Windows, macOS ou Linux).

- Lancez le fichier téléchargé et suivez l’assistant d’installation, comme pour un logiciel classique.

(source : documentation LLM Studio – Installation)

Sur Windows et macOS, vous n’avez pas besoin de connaissances avancées : l’installation se fait comme pour n’importe quelle application de bureau.

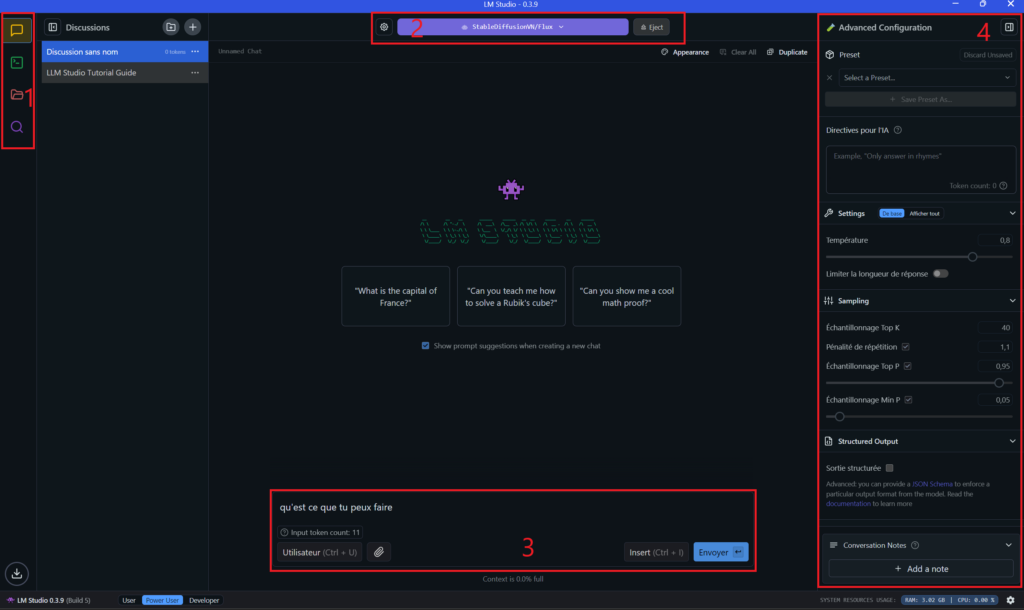

le zones en rouges sont :

1 > Discussion avec le modèle d’IA chargé

2 > Chargez votre modèle

3 > Zone de prompt, demandez ce que vous voulez à votre machine

4 > Configurer votre modèle

Navigation ,le menu de gauche

Discussion > pour utiliser votre modèle en mode prompt basique

Developpeur > créer et programmation assistée avec l’IA

Modéle enregistré sur votre ordinateur

Trouver des modéle (cf encart dédié 2)

Étape 2 – Télécharger un premier modèle

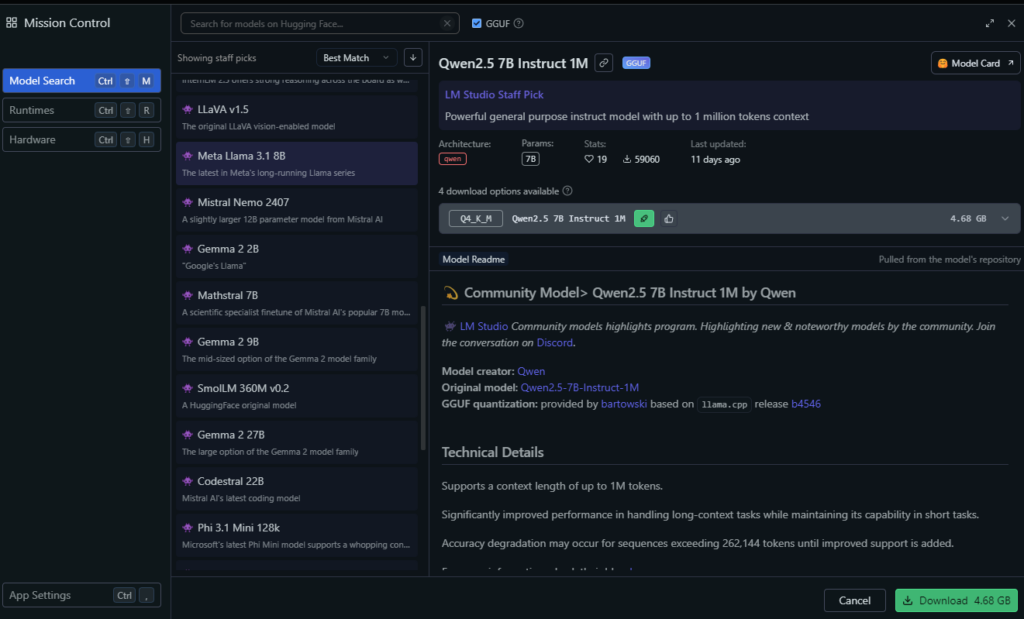

L’installation terminée, vous pouvez télécharger votre premier modèle directement depuis l’interface de LLM Studio, via l’onglet dédié à la découverte des modèles (source : documentation LLM Studio – App).

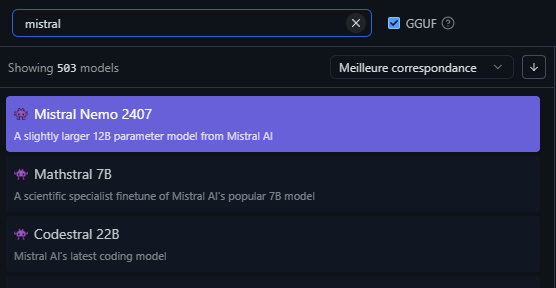

- Ouvrez LLM Studio.

- Accédez à l’onglet Discover.

- Recherchez un modèle dans la barre de recherche, par exemple « Mistral », « Llama » ou « Phi ».

- Choisissez une variante adaptée à votre machine (taille du modèle, version quantisée plus légère si nécessaire).

- Cliquez sur Download pour lancer le téléchargement et l’installation du modèle.

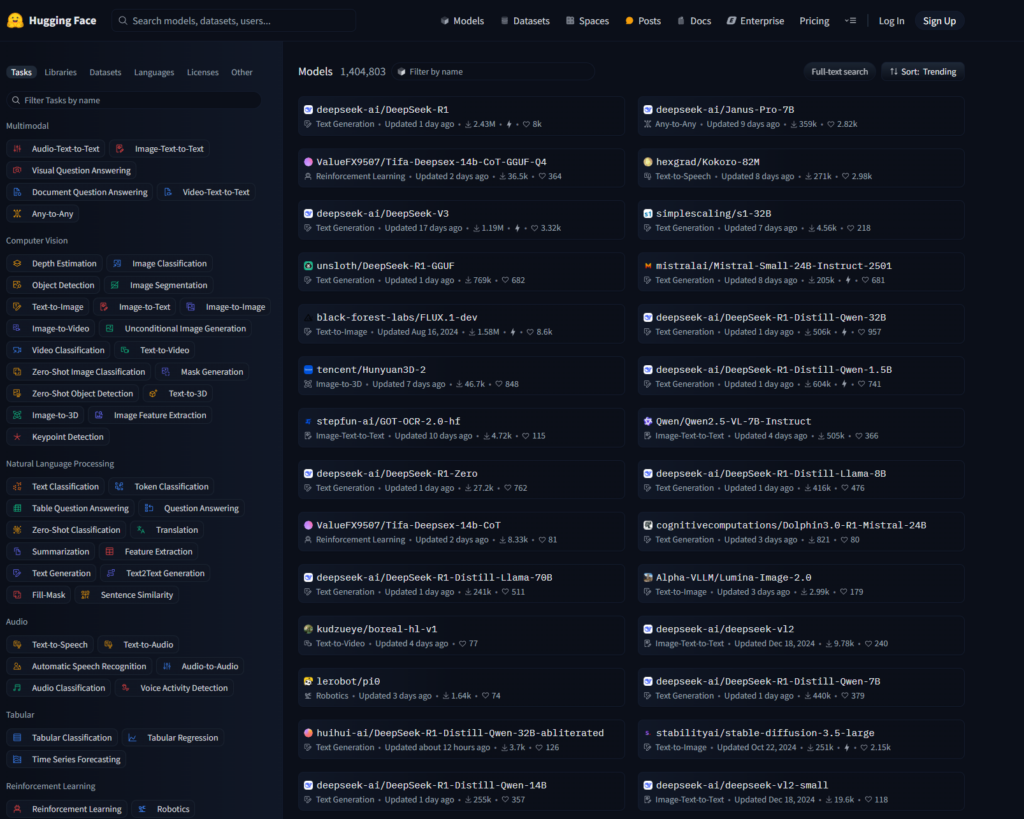

En cliquant sur la loupe vous aurez la possibilité d’installer différents modèles d’IA à entrainer ou préentrainées. Si vous ne savez quel modèle choisir, le site https://huggingface.co/ , vous pouvez les trier en fonction de vos besoins, puis dans LM Studio effectuez la recherche et installez le. Attention au poids de certains modéles.

Le Chat

Pour le Chat de Mistral, choisissez Mistral Nemo

(sources : documentation LLM Studio, article CodeGPT)

Étape 3 – Discuter avec le modèle

Une fois le modèle téléchargé, vous pouvez interagir avec lui via le mode « chat » de LLM Studio (source : documentation LLM Studio – Interface de chat).

- Dans LLM Studio, sélectionnez le modèle que vous venez d’installer.

- Créez une nouvelle session de chat.

- Saisissez votre prompt dans la zone de texte, comme vous le faites déjà avec d’autres IA.

- Lancez la génération et observez la réponse du modèle.

Selon le mode choisi (User, Power User, Developer), vous pouvez afficher plus ou moins de paramètres (température, longueur maximale, etc.) (source : documentation LLM Studio – Modes d’interface).

La colonne de droite peut

En contexte de formation, le mode User est adapté à une première prise en main, tandis que le mode Power User permet de montrer l’impact des paramètres sur le style et la créativité des réponses.

Étape 4 – Aller plus loin : documents, API locale et presets

Utiliser vos propres documents

LLM Studio permet d’associer des documents locaux (PDF, documents texte, etc.) à une session afin que le modèle puisse s’appuyer dessus pour répondre aux questions (source : documentation LLM Studio – Documents).

Cette approche est idéale pour créer un « assistant documentaire » privé, alimenté par vos procédures internes, vos supports de cours ou vos manuels.

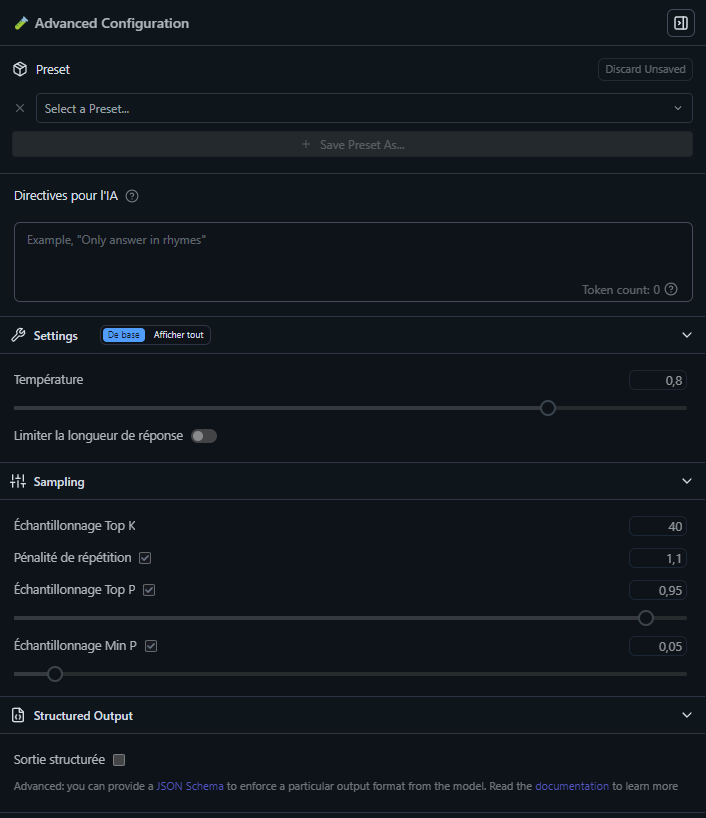

Créer et réutiliser des presets

La colonne de droite de LLM Studio, intitulée « Advanced Configuration », fournit un ensemble d’options de configuration avancée pour les utilisateurs expérimentés qui souhaitent personnaliser davantage le comportement et les fonctionnalités de la plateforme.

Spécifiez lui un contexte général, et une capacité à la prise de risque dans la réponse (autrement température, c’est le degré de créativité de l’IA -d’où la prise de risque)

Qu’est ce que le « Sampling » : Lorsqu’un modèle de langage comme GPT génère du texte, il prédit plusieurs mots possibles avec différentes probabilités. Le Sampling permet de ne pas toujours choisir le mot ayant la probabilité la plus élevée, ce qui introduit de la diversité et évite des textes trop répétitifs ou prévisibles.

LLM Studio permet de créer des presets : vous définissez un prompt système (le rôle de l’IA) et un ensemble de paramètres (température, longueur de réponse, etc.), puis vous réutilisez cette configuration à chaque nouvelle session (source : LLM Studio – Presets).

Pour un centre de formation, vous pouvez par exemple créer des presets tels que :

- « Rédacteur pédagogique » ;

- « Coach bureautique » ;

- « Assistant WordPress ».

Chaque preset devient un profil d’IA prêt à l’emploi pour vos besoins spécifiques.

Connexion possible aux API

LLM Studio propose également un mode serveur qui expose une API locale, avec des endpoints compatibles OpenAI (chat, responses, embeddings). Vous pouvez ainsi envoyer des requêtes HTTP depuis vos scripts ou outils d’automatisation (source : LLM Studio – Developer Server).

Concrètement, de nombreux outils qui fonctionnent avec l’API OpenAI peuvent être redirigés vers votre modèle local en adaptant l’URL et la clé d’API, ce qui en fait une brique intéressante pour vos workflows internes.

4. Avantages et limites d’une IA locale

Avantages principaux

- Confidentialité : les données restent dans votre machine ou votre réseau privé, ce qui est cohérent avec une politique de protection des données (sources : lmstudio.ai, CodeGPT – LLM Studio).

- Fonctionnement hors-ligne : une fois les modèles téléchargés, vous pouvez utiliser LLM Studio sans connexion Internet, ce qui est utile en mobilité ou dans des environnements isolés (source : documentation LLM Studio).

- Coût maîtrisé : vous investissez dans le matériel une fois, puis vous pouvez expérimenter autant que nécessaire sans facture au token.

Limites à anticiper

- Performance dépendante du matériel : sur une configuration modeste (CPU uniquement, peu de RAM), les temps de réponse seront plus longs (sources : guides LLM locaux, par exemple XDA – Using LLMs locally).

- Taille des modèles : certains modèles très récents et très performants sont trop lourds pour un poste grand public et nécessitent des GPU puissants.

- Suivi des modèles open-source : il faut garder un œil sur l’évolution de l’écosystème (nouvelles versions, licences, langues supportées) pour sélectionner les modèles adaptés à vos cas d’usage.

5. Exemples d’usage concrets pour un centre de formation ou une petite entreprise

Assistant pédagogique local

[Inference] Vous créez un preset « Formateur bureautique » dans LLM Studio, vous lui fournissez vos supports de cours, puis vous laissez les stagiaires poser des questions à l’IA sur le contenu. L’ensemble des échanges reste limité à la machine qui exécute LLM Studio.Chatbot interne pour une TPE/PME

En exposant l’API locale de LLM Studio, vous branchez un intranet, une application interne ou un outil no-code afin de répondre aux questions fréquentes sur les procédures internes, le support ou l’onboarding.

Laboratoire d’expérimentation IA

Dans un module « IA pour l’entreprise », vous comparez un LLM local via LLM Studio à un LLM cloud via API : vous faites travailler vos apprenants sur les aspects performance, coût et gouvernance des données, en montrant les avantages et limites de chaque approche.

6. Exercice d’application pour vos apprenants

Si vous utilisez cet article comme support pédagogique, vous pouvez proposer l’exercice suivant :

- Installer LLM Studio sur un poste de test (ou utiliser un poste déjà équipé).

- Télécharger un modèle de petite taille (par exemple une variante « small » de Phi ou Mistral).

- Créer un preset « Assistant FAQ formation » avec un prompt système qui explique le rôle de l’IA (répondre aux questions des stagiaires) et des paramètres modérés (température, longueur de réponse).

- Formuler cinq questions typiques d’un stagiaire sur votre offre de formation (inscription, prérequis, contenu, modalités) et analyser ensemble la pertinence des réponses produites par l’IA.

7. Conclusion – LLM Studio comme brique de votre écosystème IA

LLM Studio est aujourd’hui une solution accessible pour exécuter des LLM en local : interface graphique claire, fonctionnement hors-ligne après téléchargement, et possibilité d’exposer une API compatible OpenAI pour vos intégrations internes (sources : lmstudio.ai, LLM Studio – Developer Server).

Pour un centre de formation ou une petite structure, c’est un bon point de départ pour :

- expérimenter l’IA sans dépendre uniquement des plateformes cloud ;

- sensibiliser vos publics à la confidentialité et à la gouvernance des données ;

- préparer une montée en compétences plus globale sur l’IA et le numérique, par exemple dans un parcours aligné sur DigComp 2.2.

13. Webographie

- LLM Studio – Site officiel, https://lmstudio.ai, consulté le 10 décembre 2025.

- LLM Studio – Documentation de l’application, https://lmstudio.ai/docs/app, consulté le 10 décembre 2025.

- LLM Studio – Documentation serveur / API locale, https://lmstudio.ai/docs/developer/core/server , consulté le 10 décembre 2025.

- LLM Studio – Documentation presets, https://lmstudio.ai/docs/developer/core/presets , consulté le 10 décembre 2025.

- CodeGPT – « LM Studio AI: Run Powerful LLMs Locally », https://www.codegpt.co/blog/lm-studio-ai , consulté le 10 décembre 2025.

- XDA Developers – « Ways anyone can use LM Studio to run local LLMs », https://www.xda-developers.com/ways-anyone-use-lm-studio-local-llm/ , consulté le 10 décembre 2025.

- Hugging Face – Plateforme de modèles open-source, https://huggingface.co , consulté le 10 décembre 2025.